InfiniBand: 支援高效能运算革命的强大网路架构

在过去的数十年里,InfiniBand和乙太网持续竞争网路通信世界的主导地位。作为被最广泛使用的网路通讯协议,乙太网拥有优秀的性价比以及和多数装置兼容的优势。

然而,现今网路早已发展成一个更为庞大复杂的系统,大量的数据运算需求让人们开始关注InfiniBand架构的优势,包含:

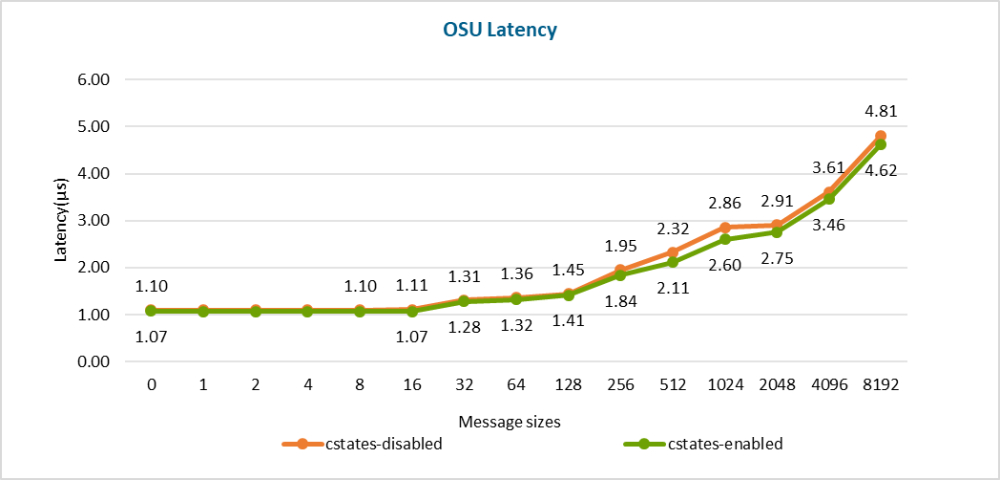

高效率、低延迟

InfiniBand为目前最高效率的网路通讯架构,具有高吞吐量和极低的延迟。 InfiniBand在网路内部整合了运算引擎,有效加速深度学习和高性能运算(HPC)的资料处理。

InfiniBand latency with switch

InfiniBand latency with switch

Source:DELL Technologies

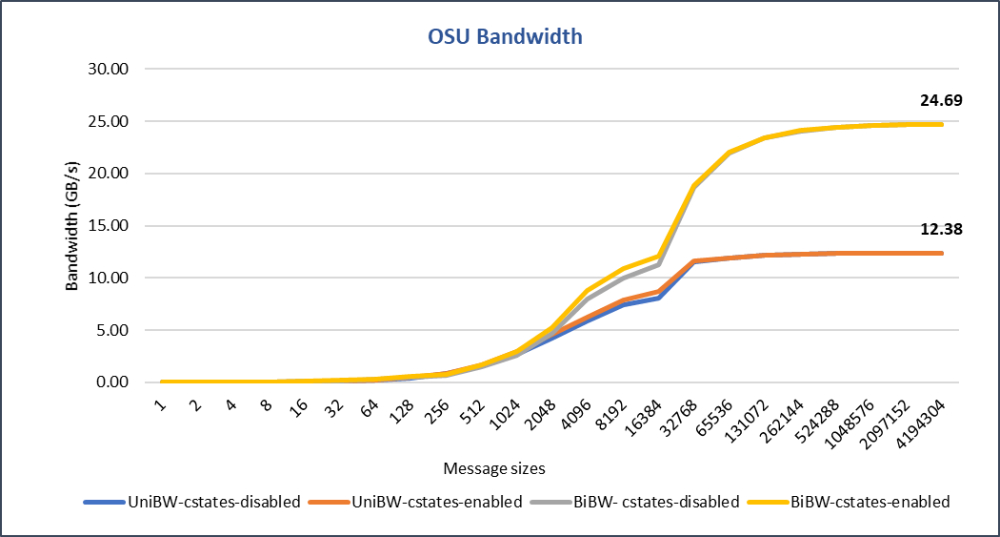

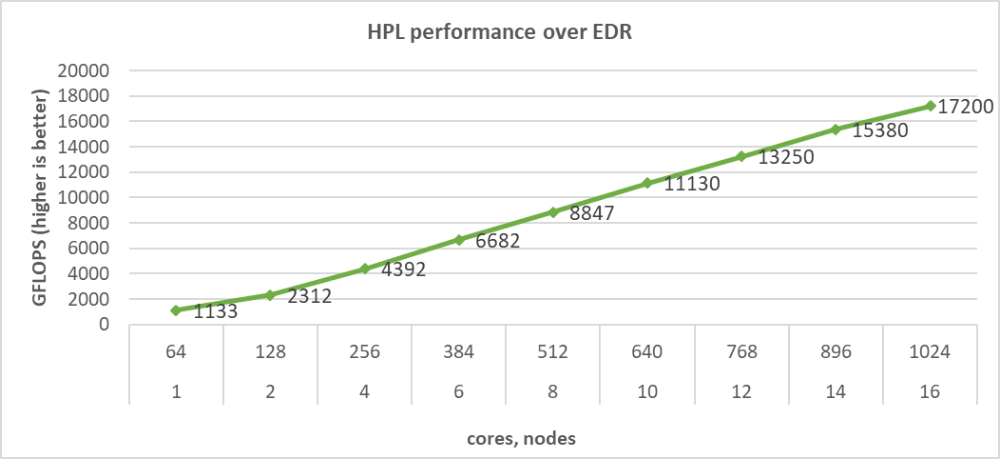

可扩展性

InfiniBand具有高度可扩展的架构。它可以在一个子网内支持成千上万的节点,也可通过路由器进行扩展,创造近乎无限的规模。

另一方面,乙太网的架构在扩展方面有其局限性。除了需要额外的路由器、交换机;在数据中心里,DAC(Direct Attach Cable)无源铜缆只能用于10公尺之内。此外,乙太网扩充后传输速度也受到限制。

HPL across 16 servers

Source:DELL Technologies

支援RDMA

InfiniBand支援RDMA(远端直接记忆体存取),这项技术允许使用者的应用程式直接读取或写入远端记忆体,无核心干预和记忆体拷贝发生。因此非常适用于伺服器与储存设备间的连线。

上述原因使InfiniBand为高性能计算(HPC)、深度学习和大规模云资料中心…等领域的发展带来更多的可能性。

| 优势 | 缺点 | |

|---|---|---|

| 乙太网 |

|

|

| InfiniBand |

|

|

InfiniBand的领导者: Mellanox

InfiniBand领域的领导企业包含Mellanox和英特尔。 Mellanox于2019年被NVIDIA集团收购,是目前InfiniBand半导体的领先品牌,为伺服器、通信、资料存储和嵌入式系统市场提供完整解决方案。由于其优秀的可扩展性以及和各种式晶片(如X86、ARM、POWER和GPU…等)的相容性,越来越多的HPC使用者选择Mellanox的InfiniBand网路。

正凌有幸能参与由InfiniBand带来的高效能运算革命。包括QSFP+, QSFP28及QSFP-DD…等产品的I/O连接器系列已被InfiniBand领导品牌采用多年。 SFP系列产品除了可支援InfiniBand也可支援乙太网架构。

| Name | Abbreviation | Raw Signling Rate | Applied Encoding | Effective Data Rate | Aggregated(4x) Throughput | module |

|---|---|---|---|---|---|---|

| Single Data Rate | SDR | 2.5Gb/s | 8b/10b | 2Gb/s | 8Gb/s | CX4/SFF-8470 |

| Double Data Rate | DDR | 5Gb/s | 8b/10b | 4Gb/s | 16Gb/s | CX4/SFF-8470 |

| Quad Data Rate | QDR | 10Gb/s | 8b/10b | 8Gb/s | 32Gb/s | QSFP+ |

| Fourteen Data Rate | FDR | 14.1Gb/s | 64b/66b | 13.64Gb/s | 54.5Gb/s | QSFP+ |

| Enhanced Data Rate | EDR | 25.8Gb/s | 64b/66b | 25Gb/s | 100Gb/s | QSFP28 |

| High Data Rate | HDR | 51.6Gb/s | 64b/66b | 50Gb/s | 200Gb/s | QSFP DD |

| Next Data Rate | NDR | TBD | TBD | TBD | TBD | TBD |